“服务器轻微抖动”,腾讯用五个字概括了12月12日的微信故障。但对技术人员来说,这42分钟里的每一秒,都是与故障的赛跑。当我们在抱怨消息发不出去时,上海漕河泾的数据中心里,一场无声的“灭火行动”早已展开。

故障的根源,要从一台冷却泵说起。根据腾讯后续披露的技术复盘,下午两点三十二分,上海漕河泾IDC 3号楼的冷却泵P-03B突然出现轴承异常,导致冷冻水流量下降30%。高温迅速传导到GPU集群,当温度超过85℃时,服务器自动触发降频保护——这正是我们手机发烫时会变卡的原理,只不过发生在承载亿级用户的服务器上。

两分钟后,消息同步服务的队列延迟飙升至18秒,相当于我们发一条消息,要等半分钟才能被接收。更棘手的是,大量用户发现消息发送失败后,开始反复点击重试,引发了“重试风暴”,直接耗尽了Redis连接池,让故障范围进一步扩大。这就像一条堵车的马路,越催越堵,形成恶性循环。

下午两点四十分,自动化脚本启动,将故障区域的流量紧急切换至深圳坪山IDC。这步“异地容灾”操作是关键——就像家里的电路跳闸后,自动切换到备用电源。腾讯的技术团队早已搭建起“多活架构”,确保单一数据中心出问题时,服务能无缝衔接。

流量切换后,技术人员开始着手修复核心问题。他们利用“影子队列”技术,重放了故障发生后5分钟内的所有消息,确保没有一条数据丢失。这就像给断裂的视频重新拼接画面,既要完整,又不能出现重复。下午三点零六分,经过1000个核心群的灰度验证,确认服务无异常后,全量开放功能。三点十八分,所有用户的微信恢复正常。

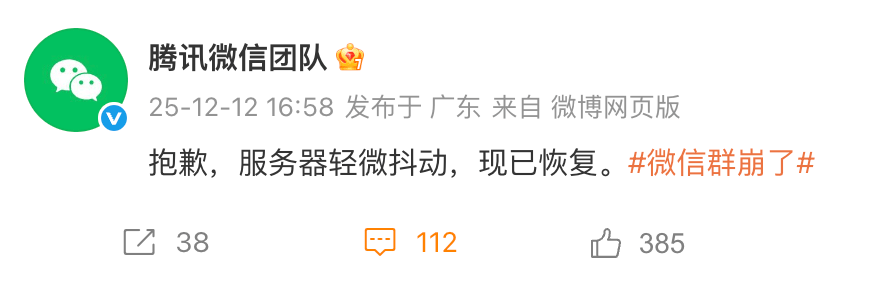

42分钟的故障,腾讯用“8分钟定位根因、20分钟完成流量切换、36分钟全量修复”的速度,交上了答卷。但比修复速度更重要的,是后续的改进措施。腾讯宣布,将在2025年第三季度完成“三城五IDC”的异地多活架构升级,把故障恢复时间(RTO)压缩到30秒以内,实现“消息级”灾备。

在运维层面,冷却系统将被纳入“数字孪生”监控,只要轴承振动超过5mm/s就会自动预警,从源头避免类似问题。同时,每季度将举行“红蓝对抗”演练,模拟IDC级故障,让技术团队在实战中提升应急能力。这些措施,就像给服务器穿上“防弹衣”,虽然不能完全杜绝故障,但能把风险降到最低。

有人问,为什么微信这样的巨头还会出故障?答案很简单:在14亿用户的超级App面前,没有“小问题”。就像城市供电系统,哪怕只是一根电线出问题,都可能导致一片区域停电。微信的每一次“抖动”,都是对互联网基础设施韧性的考验。

这次故障也给整个行业提了醒:超大规模IM工具的“微故障”,可能因用户的重试行为放大为“大感知”。未来,技术的竞争不仅是功能的创新,更是稳定性的比拼。当腾讯把“异地多活”写入技术白皮书时,我们知道,下一次微信再遇到问题,恢复速度或许会更快——这就是故障带来的进步。